Интересное сегодня

Косвенная роль восприятия ожиданий выживания в связи между в...

Введение Понимание того, как надежда может защищать от суицида, может улучшить эффективность профила...

Как научиться долгосрочному финансовому планированию

Введение Эксперт в области личных финансов Дейв Рэмси широко известен своим изречением: "Если вы буд...

Влияние пандемии COVID-19 на распространенность депрессии ср...

Введение Депрессия является серьезным расстройством психического здоровья, которым страдают взрослые...

Преимущества оценки мастерства в экшн-видеоиграх для предска...

Введение Видеоигры привлекают внимание миллионов людей и исследователей, которые изучают их влияние ...

Влияние родительской привязанности на отношения в парах

Введение Человеческие отношения представляют собой парадоксальное взаимодействие между нашей врожден...

Влияние процессов отвлекающих факторов на визуальный поиск у...

Введение Визуальный поиск — это ежедневная задача, которая позволяет нам находить целевой объект сре...

Введение

Широкое использование термина «доверительный ИИ» вызывает дебаты среди производителей и законодателей. Некоторые философы утверждают, что доверять машинам иррационально, и доверие должно быть направлено на людей, ответственных за разработку и внедрение ИИ. Другие, такие как Coeckelbergh, утверждают, что доверие к машинам должно быть распространено, как и к другим социальным агентам.

Те, кто выступают против доверия машинам, утверждают, что доверие может быть рационально применено только к агентам, чувствительным к нормативным ограничениям, действующим с благосклонностью или обладающим моральной чувствительностью. Современные машины не обладают этими качествами, поэтому многие специалисты по этике ИИ предлагают использовать понятие надежности вместо доверия.

Методы

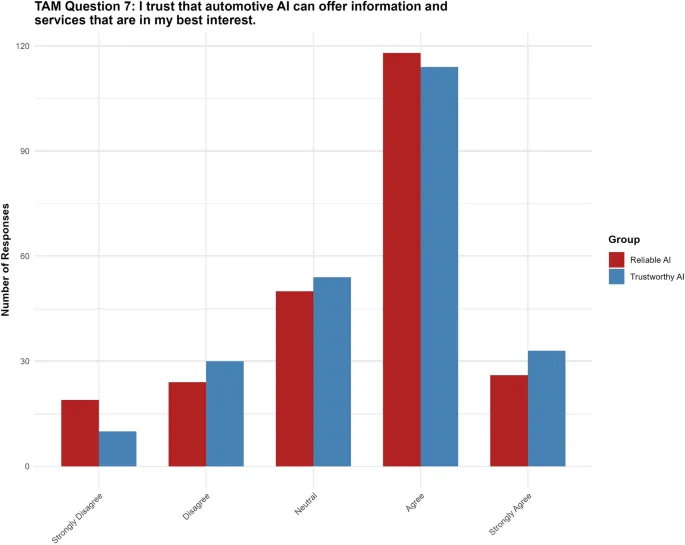

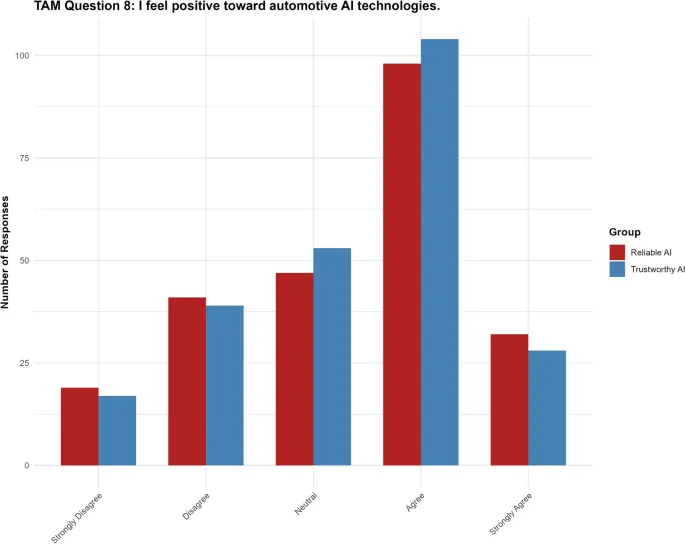

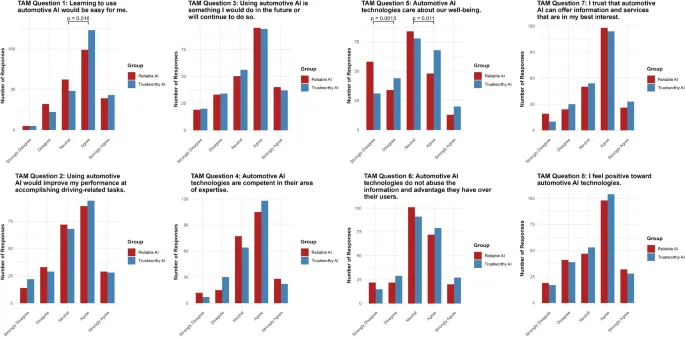

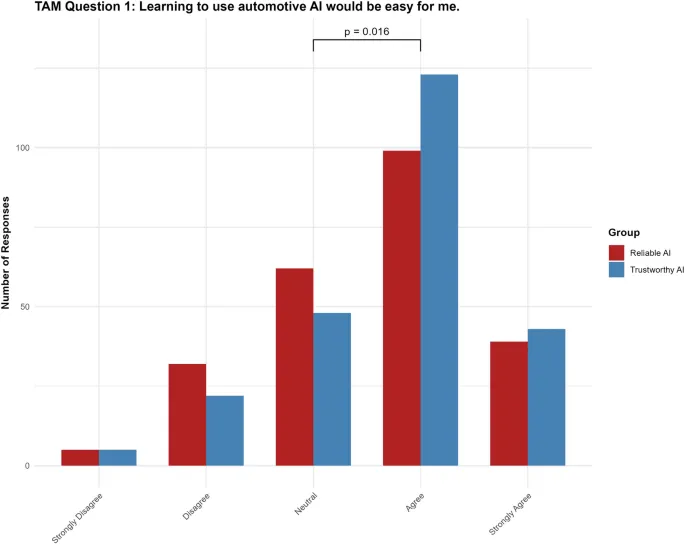

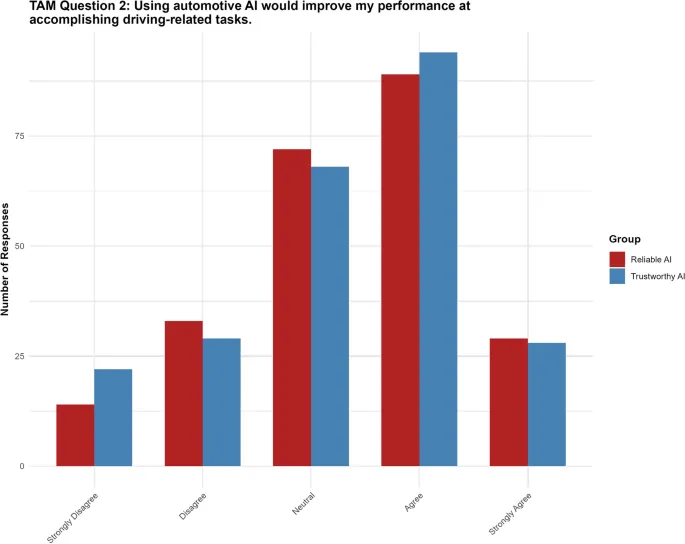

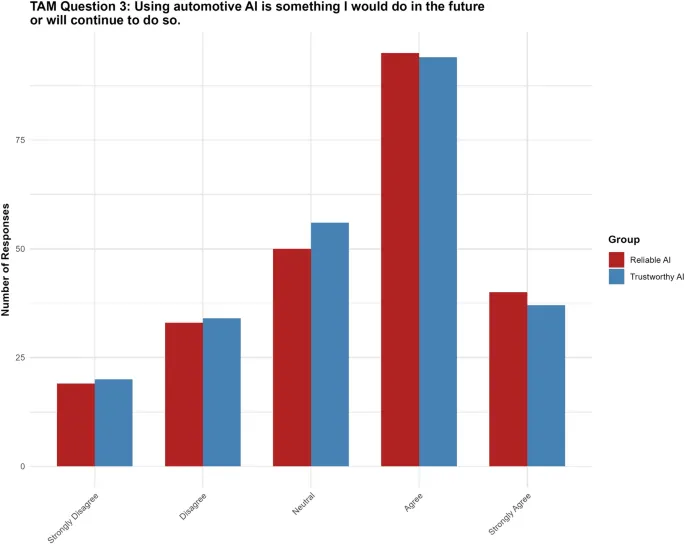

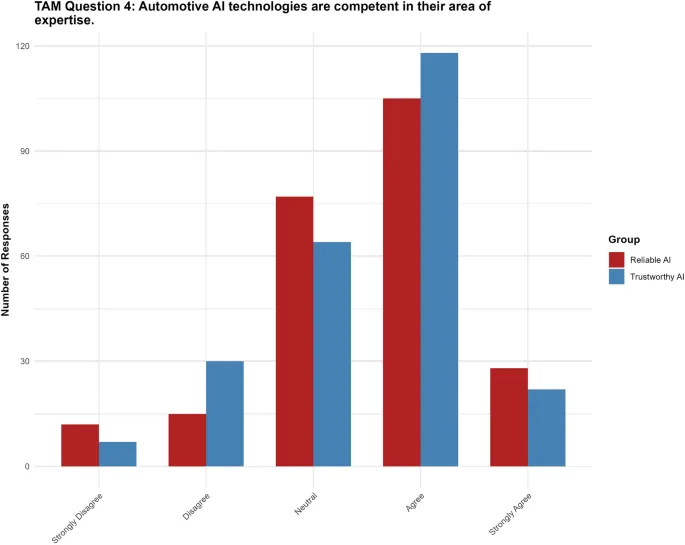

Исследование использует однофакторный межгрупповой дизайн с 478 участниками, разделенными на две группы: «доверительный ИИ» и «надежный ИИ». Участники оценивали три сценария и заполняли модифицированную версию Модели принятия технологии (TAM), которая охватывает различные переменные, такие как воспринимаемая легкость использования, человекоподобное доверие и общее отношение.

Результаты

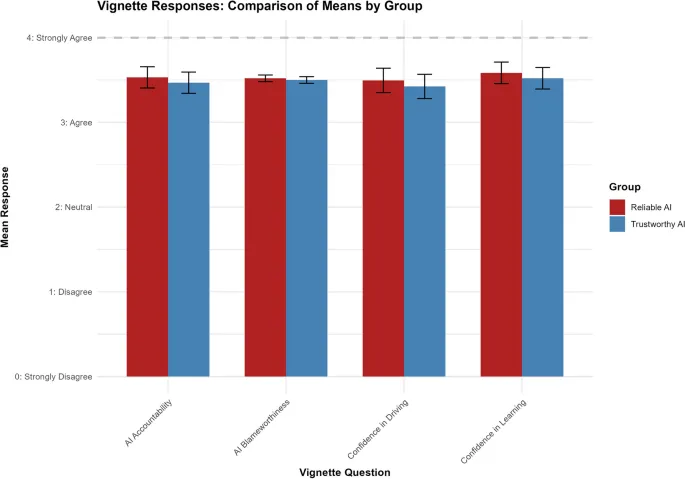

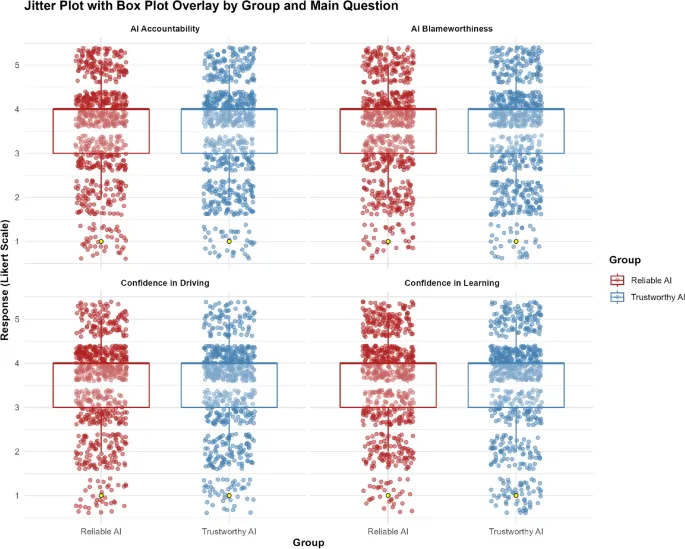

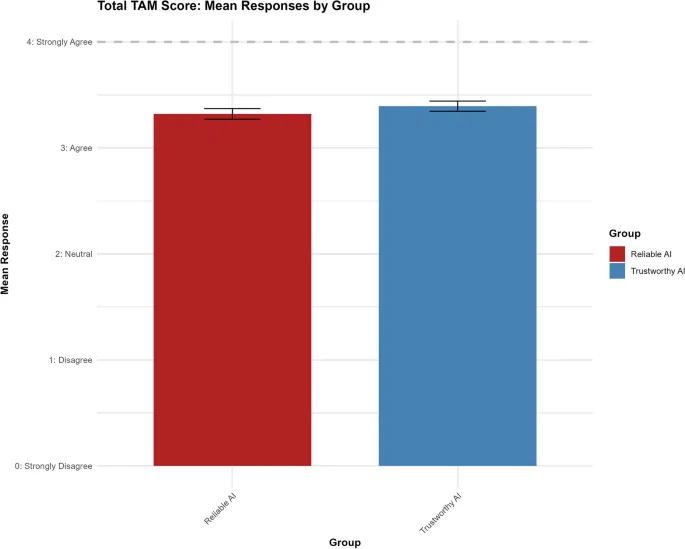

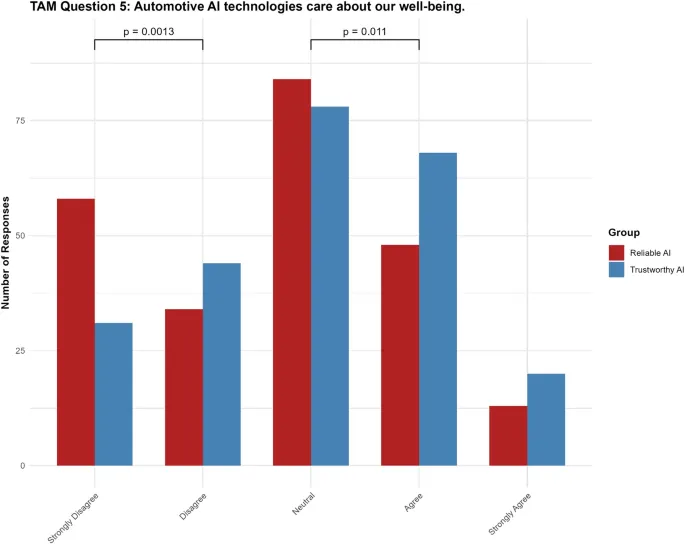

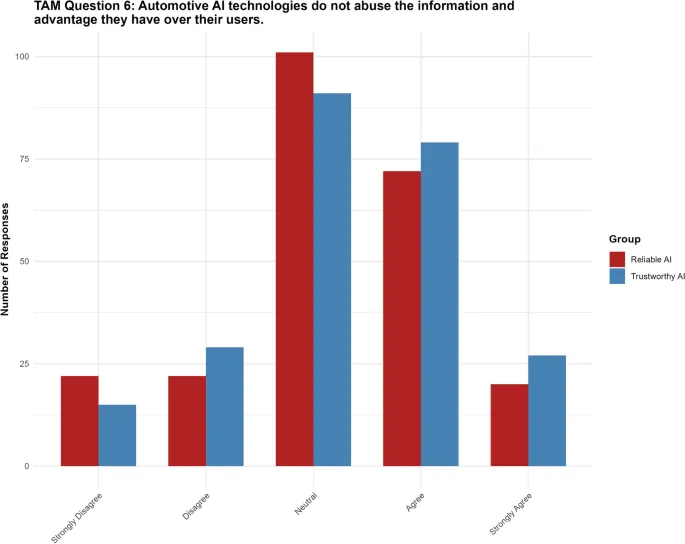

Маркировка ИИ как «доверительного» не значительно влияла на суждения участников по конкретным сценариям, но увеличивала воспринимаемую легкость использования и человекоподобное доверие, что указывает на влияние на удобство использования и антропоморфизацию восприятия пользователей.

Обсуждение

Исследование показало, что маркировка ИИ как «доверительного» не значительно влияет на оценки пользователей или принятие технологии, за исключением увеличения восприятия ИИ как заботящегося о благополучии людей. Эти результаты имеют важные практические и этические последствия для разработчиков и политиков.

Ограничения

Исследование имеет несколько ограничений, включая возможное влияние фрейминга на восприятие участников и необходимость дальнейших исследований для оценки влияния маркировки на другие технологии ИИ.

Заключение

Маркировка ИИ как «доверительного» или «надежного» не значительно влияет на оценки пользователей или принятие технологии, за исключением восприятия ИИ как заботящегося о благополучии людей. Эти результаты подчеркивают важность использования надежности вместо доверия в разработке и внедрении ИИ.