Интересное сегодня

Влияние разнообразия команд на их эффективность: вариативнос...

Введение Разнообразие в современных организациях превратилось из прогрессивного идеала в стратегичес...

Модели принятия решений с непрерывным ответом: теория и оцен...

Введение в модели непрерывного принятия решений Люди часто принимают решения между непрерывными альт...

Как сенсомоторная память влияет на движения, но не на осязан...

Введение Успешное взаимодействие человека с окружающим миром требует обработки соответствующих сенсо...

Как негативный опыт формирует эмпатию у животных

Введение Последние исследования раскрыли механизм работы мозга в предлобной коре, который определяет...

Медитация на основе осознанности: інтервенція для лечения де...

Применение медитации на основе осознанности в лечении депрессии Тренировка осознанности была введена...

Влияние неблагоприятного детского опыта на развитие личности

ВведениеНеблагоприятные детские переживания (НДП), также известные как ранние жизненные трудности, о...

Проблема климатической дезинформации

Дезинформация о климате снижает осведомленность общества и подрывает поддержку мер по смягчению последствий изменений климата. Попытки донести научные факты часто нивелируются ложными утверждениями, что усиливает поляризацию в обществе. Для противодействия этому требуются комплексные решения, объединяющие технологии и психологию.

Роль психологических и технологических методов

Психологические исследования показывают, что эффективные методы борьбы с дезинформацией включают как фактологическую коррекцию (разъяснение научных данных), так и разоблачение манипулятивных техник (логических ошибок и риторических уловок). Однако автоматическое обнаружение таких ошибок в климатической дезинформации остается малоизученной областью.

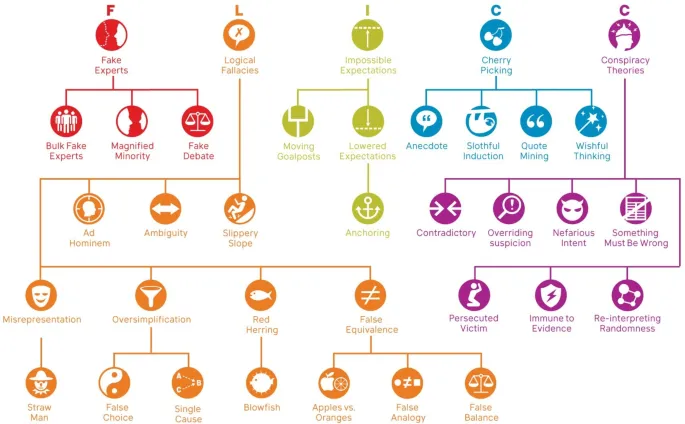

Разработка модели обнаружения ложных аргументов

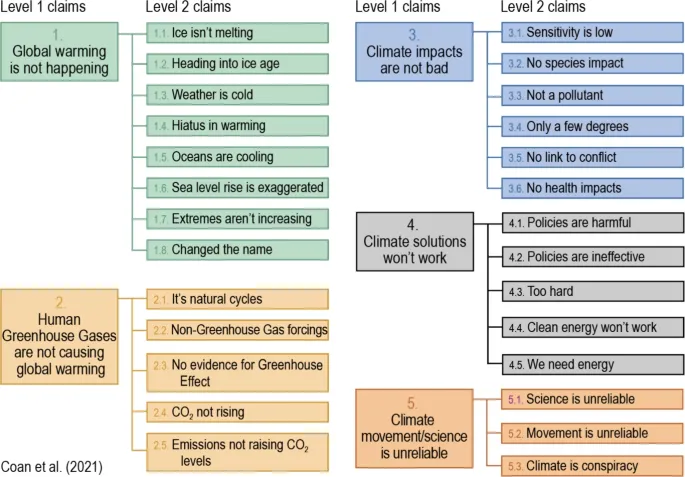

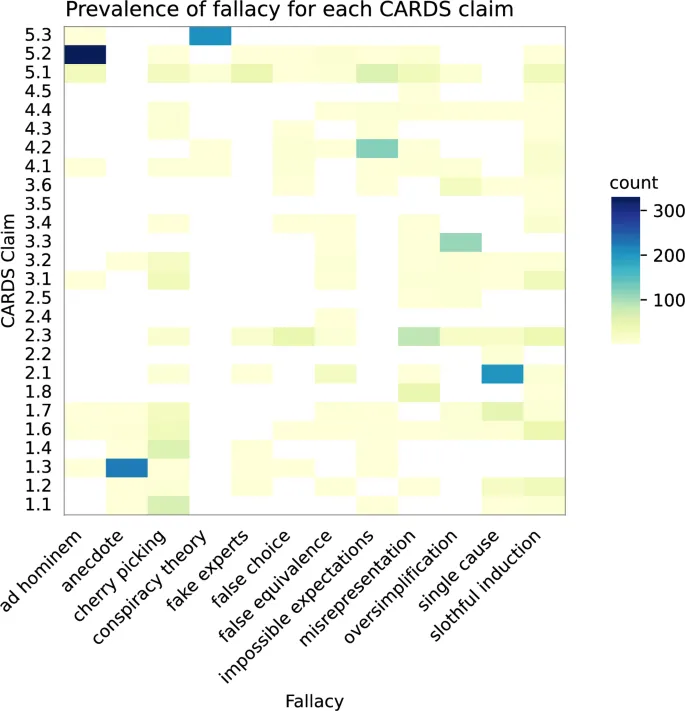

В данном исследовании применяется технокогнитивный подход, объединяющий критическое мышление и машинное обучение. На основе таксономий FLICC (Fake experts, Logical fallacies, Impossible expectations, Cherry picking, Conspiracy theories) и CARDS (Computer Assisted Recognition of Denial and Skepticism) был создан датасет, связывающий примеры климатической дезинформации с конкретными логическими ошибками.

Обучение и оценка модели

Датасет использовался для обучения модели на основе архитектуры DeBERTa. Производительность оценивалась с помощью метрики F₁, которая учитывает как точность, так и полноту предсказаний. Результаты показали, что модель превосходит предыдущие разработки в 2.5–3.5 раза.

- Легче всего обнаруживаются аргументы с ложными экспертами и анекдотическими свидетельствами.

- Сложнее выявлять ошибки, требующие контекстных знаний, такие как упрощение, искажение фактов и ленивая индукция.

Перспективы и этические вопросы

Модель демонстрирует высокую эффективность в обнаружении логических ошибок, но ее можно улучшить за счет увеличения датасета и уточнения классификации сложных случаев. Важно учитывать этические аспекты: технологии борьбы с дезинформацией не должны использоваться для цензуры, а должны способствовать развитию критического мышления.

«Технокогнитивный подход объединяет силу технологий и психологии, чтобы дать людям инструменты для распознавания манипуляций»

Дальнейшие исследования могут быть направлены на интеграцию этой модели с системами автоматического опровержения, а также на адаптацию под другие темы, такие как дезинформация о вакцинах.