Интересное сегодня

Как классический визуальный поиск предсказывает результаты в...

Активный визуальный поиск в естественных условиях отражает индивидуальные различия в классической по...

Как мобильность способствует инновациям: уроки науки для кре...

Важность мобильности для научных открытий Недавнее исследование, проведенное учеными из Университета...

Влияние негативного детского опыта (НДО) на физическое и пси...

Введение Негативный детский опыт (НДО) относится к различным негативным событиям или факторам окружа...

Как аудиовизуальные стимулы вызывают иллюзию внетелесного оп...

Иллюзия внетелесного опыта и мультисенсорная интеграцияВиртуальная реальность (VR) позволяет пользов...

Как активное дыхание помогает справляться со стрессом

Введение Не позволяйте стрессу искажать вашу реальность. Ваша голова кружится, вы чувствуете себя вн...

Как виртуальные аватары помогают людям с аутизмом снизить тр...

Аутизм и социальная коммуникация: вызовы и решения Расстройство аутистического спектра (РАС) — это н...

Введение

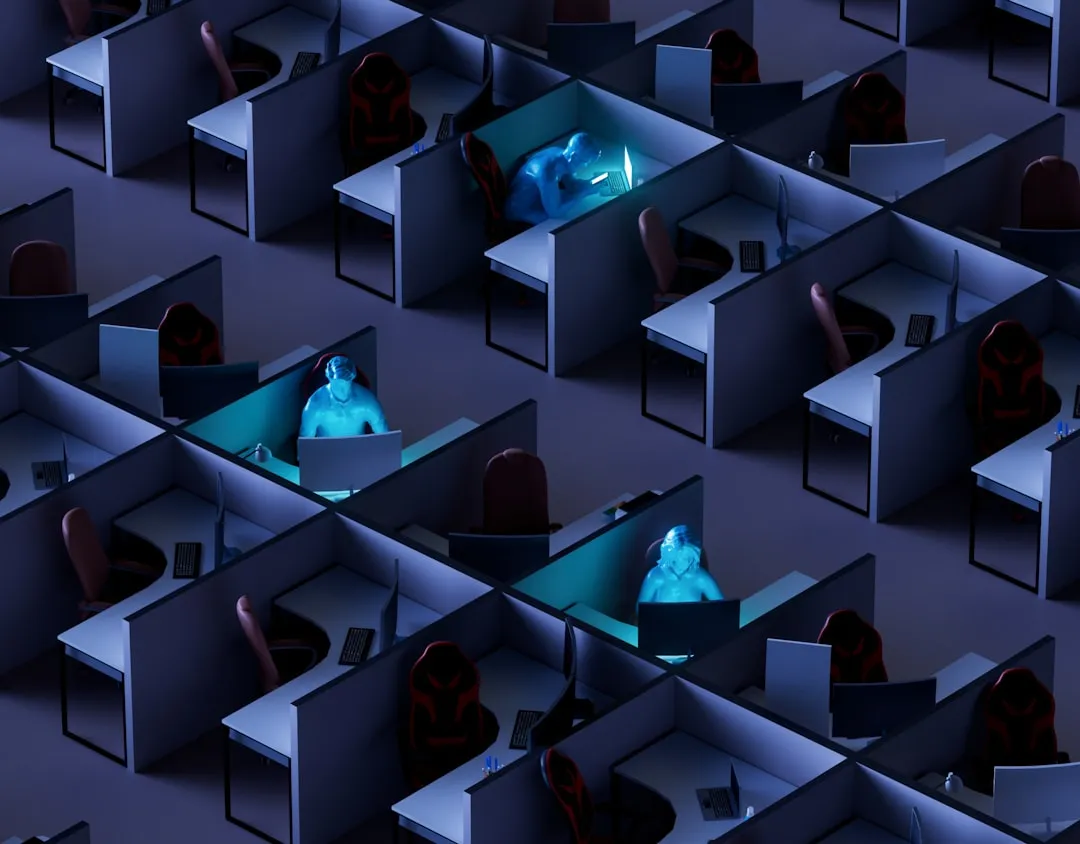

Современные достижения в области автоматизированного принятия решений и искусственного интеллекта (ИИ) изменили представления о задачах, требующих человеческого интеллекта. Например, языковые модели, способные генерировать код и текст, демонстрируют, что ИИ может автоматизировать даже творческие задачи. Это привело к убеждению, что автономные системы с ИИ могут взять на себя множество функций, включая социальные и моральные решения.

Проблема выравнивания ценностей ИИ

Однако при делегировании задач искусственным агентам могут возникать ошибки. Например, человек может выбрать агента, не соответствующего его целям, из-за непонимания его поведения или сложности настройки параметров. Это приводит к несоответствию между ожиданиями человека и действиями агента — проблеме, известной как выравнивание ценностей ИИ.

Методология

Для изучения этой проблемы использовалась коллективная дилемма риска (КДР) — модель, в которой группа участников должна достичь общего порога взносов в общественное благо за ограниченное число раундов. Если порог не достигнут, существует вероятность потери всех личных ресурсов.

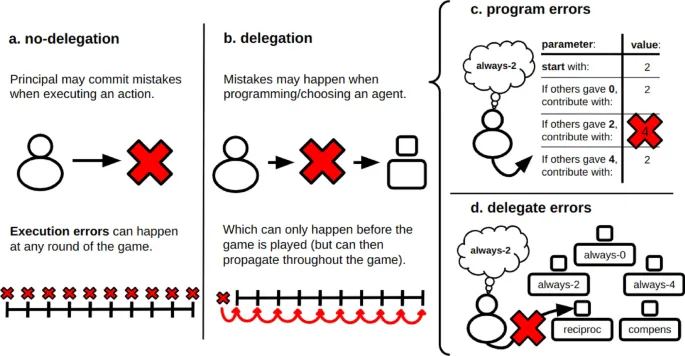

Типы ошибок

- Ошибки исполнения: возникают, когда человек принимает решения самостоятельно и ошибается в каждом раунде.

- Ошибки программирования: возникают при настройке агента, которому делегируется задача.

- Ошибки выбора агента: возникают, когда человек выбирает неподходящего предустановленного агента.

Результаты

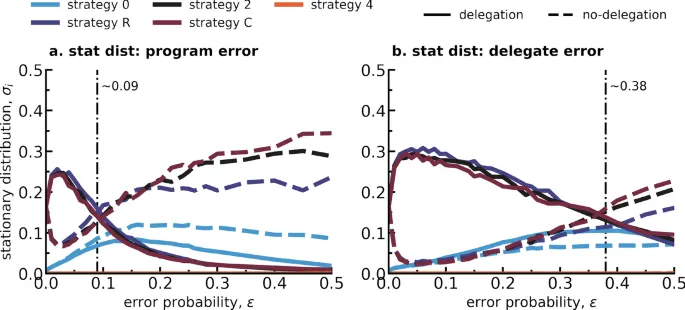

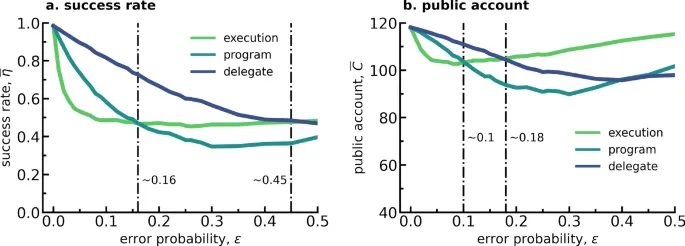

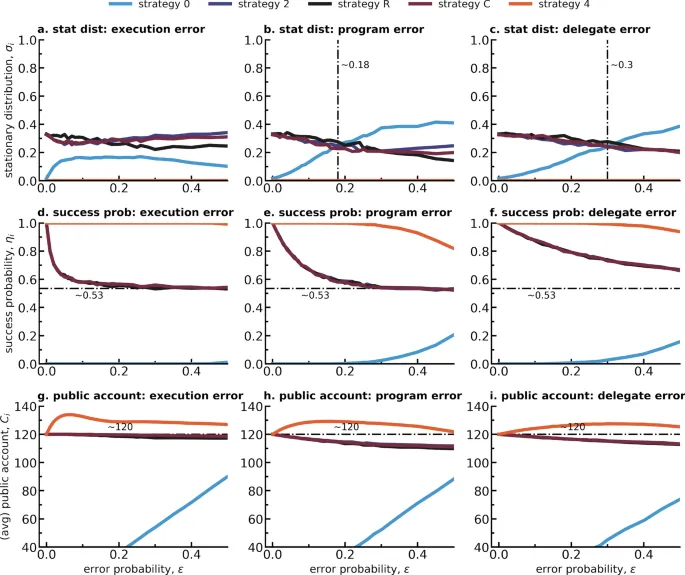

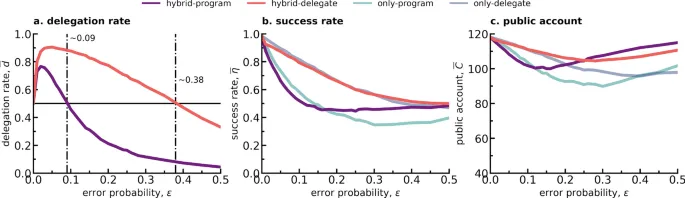

Исследование показало, что:

- Делегирование, несмотря на ошибки, приводит к более высоким показателям успеха, чем прямое принятие решений.

- При малых вероятностях ошибок (ε ≤ 0.1) делегирование через программируемых агентов дает лучшие результаты.

- При выборе из предустановленных агентов делегирование остается эффективным даже при более высоких вероятностях ошибок (ε ≤ 0.18).

Эволюционные преимущества делегирования

В долгосрочной перспективе стратегии делегирования становятся доминирующими в популяции, особенно в условиях высокого риска. Это связано с тем, что агенты стабильно исполняют заложенные стратегии, даже если они не идеальны.

Заключение

Делегирование искусственным агентам, несмотря на возможные ошибки, оказывается более эффективным, чем прямое принятие решений в условиях коллективного риска. Это открытие важно для разработки автономных систем, участвующих в социальных дилеммах.