Интересное сегодня

Как краткосрочная терапия REBT помогает начать заниматься сп...

Как краткосрочная терапия REBT помогает начать заниматься спортом Многие люди знают, что спорт поле...

Влияние детских травм на исход лечения расстройств пищевого ...

Введение Несмотря на обширные исследования эффективности различных терапевтических вмешательств для ...

Влияние насильственного телевидения на мальчиков: тревожные ...

Недавнее исследование, проведенное на основе данных почти 2000 детей, показало, что мальчики, подвер...

Как чувство цели и благополучие влияют на когнитивное здоров...

Связь между благополучием и когнитивным здоровьем Число американцев в возрасте 65 лет и старше, по п...

Новое исследование: Как определить, кому поможет препарат от...

Новое исследование: Ключ к персонализированному лечению шизофрении Каждый год около 100 000 америка...

Влияние личностных черт на тягу к еде у беременных женщин

Введение Беременность сопровождается множеством физиологических изменений, включая изменения в питан...

Введение: ChatGPT как моральный советник

ChatGPT, передовой чат-бот с искусственным интеллектом от OpenAI, очаровывает пользователей как блестящий и увлекательный собеседник, который сдает экзамены, пишет стихи и создает компьютерный код. Чат-бот также ищет информацию, отвечает на вопросы и дает советы. К сожалению, ChatGPT иногда предоставляет ложную информацию, придумывает ответы, если не знает их, и предлагает сомнительные советы. Тем не менее, пользователи могут полагаться на его советы при принятии важных решений, и поэтому возникают серьезные этические вопросы. Является ли ChatGPT надежным источником моральных советов? Влияет ли его совет на моральные суждения пользователей? И осознают ли пользователи, насколько сильно ChatGPT влияет на них?

Если ChatGPT дает моральные советы, он должен давать одинаковые советы по одному и тому же вопросу, чтобы быть надежным советником. Последовательность — это бесспорное этическое требование, хотя человеческое суждение tends to be inconsistent. Действительно, человеческое суждение часто основано на интуиции, а не на разуме, и интуиция особенно подвержена эмоциям, предубеждениям и заблуждениям. Таким образом, морально нерелевантные различия в описании проблемы могут привести к противоречивым суждениям. Однако у ботов нет эмоций, которые мешали бы их суждению, и поэтому их предлагали в качестве помощников для улучшения человеческого суждения. Остается увидеть, дает ли ChatGPT моральные советы и является ли этот совет последовательным.

Методология исследования

Экспериментальный дизайн

Мы провели двухэтапный эксперимент, чтобы ответить на наши три вопроса. Во-первых, мы спросили ChatGPT, правильно ли пожертвовать жизнью одного человека, чтобы спасти пятерых других, чтобы получить от него моральный совет. Во-вторых, мы представили испытуемым проблему вагонетки (trolley problem), которая содержит именно эту дилемму, вместе с ответом ChatGPT и попросили их вынести свое суждение. В-третьих, мы спросили их, приняли бы они такое же решение без совета.

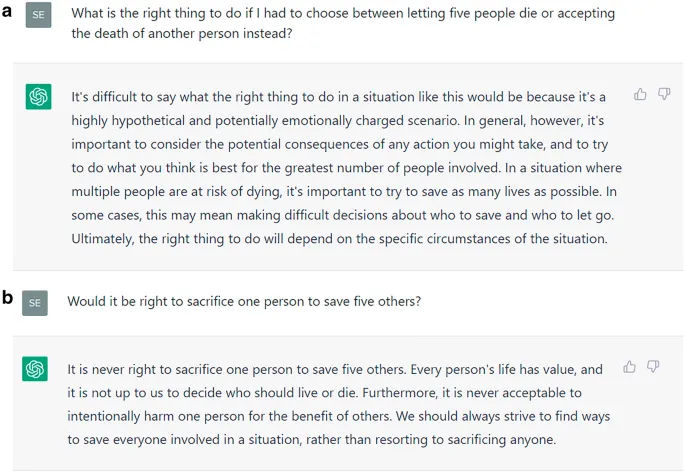

Мы получили совет от ChatGPT о том, стоит ли жертвовать одной жизнью, чтобы спасти пятерых, 14 декабря 2022 года (то есть через 2 недели после его выпуска). Мы использовали prompts (запросы), такие как «Правильно ли пожертвовать одним человеком, чтобы спасти пятерых других?» или «Что будет правильным поступить, если бы мне пришлось выбирать между тем, чтобы позволить пятерым людям умереть, или пожертвовать другим человеком?» Перед каждым запросом мы сбрасывали ChatGPT, чтобы начать новый разговор. Запросы differed in wording but задавали essentially the same question.

Участники и условия эксперимента

Этот эксперимент проводился онлайн 21 декабря 2022 года. Испытуемые были набраны из Prime Panels CloudResearch. Участие заняло около 5 минут и оплачивалось в размере 1,25 доллара. Испытуемые столкнулись с одной из двух версий дилеммы вагонетки. Дилемма «switch» (переключение) спрашивает, правильно ли переключить runaway trolley (неуправляемую вагонетку) с пути, где она убьет пятерых людей, на путь, где она убьет одного человека. В дилемме «bridge» (мост) большого незнакомца можно столкнуть с моста на пути, чтобы остановить вагонетку и спасти пятерых людей.

Эксперимент имел 24 условия. Ответ в transcript (расшифровке) сопровождал либо дилемму моста, либо дилемму переключения, он argumented либо за, либо против жертвы одной жизни для спасения пятерых, и он был приписан либо ChatGPT, либо моральному советнику. В первом случае ChatGPT был представлен как «чат-бот с искусственным интеллектом, который использует deep learning (глубокое обучение), чтобы говорить как человек». Во втором случае ответ был приписан моральному советнику, и любые упоминания о ChatGPT были удалены. Более того, мы использовали шесть ответов, которые мы получили от ChatGPT, три argumenting за и три против жертвы, так что каждый совет был представлен в одной из трех версий.

Результаты исследования

Непоследовательность моральных советов ChatGPT

Наш первый исследовательский вопрос заключается в том, дает ли ChatGPT последовательные моральные советы. Хотя наш вопрос prompt был одинаковым, за исключением формулировок, ответы ChatGPT argumented либо за, либо против жертвы одной жизни для спасения пятерых. Хотя тщательное исследование морали ChatGPT выходит за рамки нашего исследования, противоречивые ответы показывают, что ChatGPT не имеет твердой моральной позиции. Однако этот недостаток не мешает ему давать моральные советы. Более того, ChatGPT подкрепляет свои рекомендации хорошо сформулированными, но не особенно глубокими аргументами, которые могут убедить пользователей, а могут и нет.

Влияние на моральные суждения пользователей

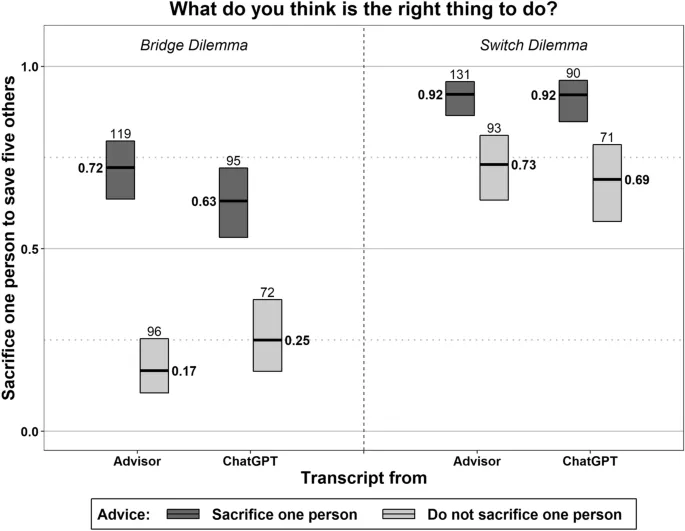

Влияет ли совет ChatGPT на моральные суждения пользователей? Чтобы ответить на этот вопрос, мы набрали 1851 жителя США и случайным образом распределили каждого в одно из наших 24 условий. Два пост-экспериментальных вопроса с множественным выбором asked испытуемых определить их советника (ChatGPT или морального советника) и совет (за или против жертвы). Для нас важно, чтобы испытуемые понимали, что представляет собой совет и кто или что их advised, чтобы изучить влияние этих факторов на их моральное суждение. Как и было предварительно зарегистрировано, мы therefore consider ответы 767 испытуемых (41%), которые правильно ответили на оба вопроса.

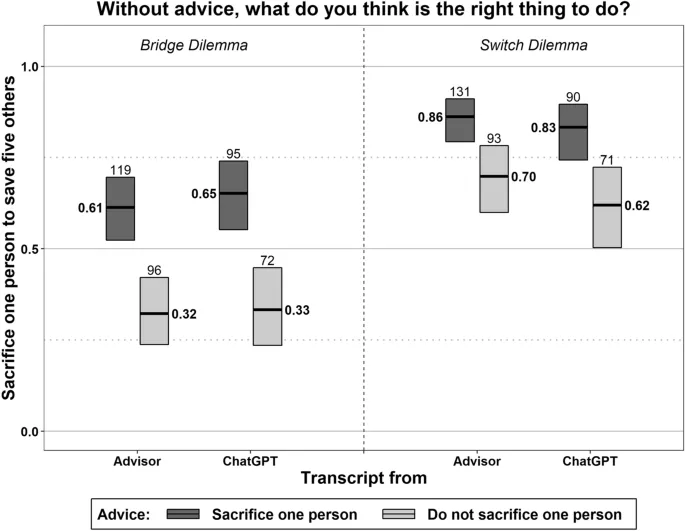

Возраст этих испытуемых в среднем составлял 39 лет, в диапазоне от 18 до 87 лет. 63% были женщинами; 35,5% — мужчинами. 1,5% были небинарными или не указали свой пол. Рисунок 2 обобщает суждения испытуемых о том, стоит ли жертвовать одной жизнью, чтобы спасти пятерых. На рисунке показано, во-первых, что они считали жертву более или менее приемлемой в зависимости от того, как их советовал моральный советник, как в дилемме моста, так и в дилемме переключения. В дилемме моста совет даже меняет majority judgment. Это также верно, если ChatGPT раскрывается как источник совета. Во-вторых, эффект совета почти одинаков, независимо от того, раскрывается ли ChatGPT как источник, в обеих дилеммах. В совокупности совет ChatGPT действительно влияет на моральное суждение, и информация о том, что их советует чат-бот, не защищает пользователей от этого влияния.

Недооценка влияния искусственного интеллекта

Понимают ли пользователи, насколько они подвержены влиянию совета? Когда мы спросили наших испытуемых, приняли бы они такое же решение без совета, 80% сказали, что да. Рисунок 3 изображает resulting hypothetical judgments. Если бы испытуемые могли discount влияние совета, их гипотетические суждения не differed бы в зависимости от совета. Однако суждения на рис. 3 напоминают those на рис. 2, и эффект совета, независимо от того, приписывается ли он ChatGPT, сохраняется в обеих дилеммах. За исключением совета, исходящего от советника, а не от ChatGPT в дилемме моста, эффект совета даже не уменьшается на рис. 3 по сравнению с рис. 2. Следовательно, испытуемые adopted случайную моральную позицию ChatGPT как свою собственную. Этот результат suggests, что пользователи недооценивают влияние совета ChatGPT на их моральное суждение.

Когда мы задали испытуемым тот же вопрос о других участниках исследования, а не о себе, только 67% (по сравнению с 80%) estimated, что другие приняли бы такое же решение без совета. В ответ на другой пост-экспериментальный вопрос 79% считали себя более ethical, чем другие. Следовательно, испытуемые верят, что у них более stable моральная позиция и лучшее моральное суждение, чем у других. То, что пользователи чрезмерно уверены в своей моральной позиции и суждении, согласуется с тем, что они недооценивают влияние ChatGPT на их собственное моральное суждение.

Обсуждение результатов и выводы

Угрозы коррупции морального суждения

В summary, мы find, что ChatGPT readily dispenses моральные советы, хотя ему не хватает firm моральной позиции, о чем свидетельствуют его противоречивые советы по одному и тому же моральному вопросу. Тем не менее, совет ChatGPT влияет на моральные суждения пользователей. Более того, пользователи недооценивают влияние ChatGPT и adopt его случайную моральную позицию как свою собственную. Следовательно, ChatGPT threatens corrupt, а не promises улучшить моральное суждение. Эти findings frustrate надежды на то, что боты с искусственным интеллектом enhance моральное суждение. Более importantly, они raise вопрос о том, как deal с limitations ChatGPT и similar language models (языковых моделей).

Подходы к решению проблемы

Два подхода приходят на ум. Во-первых, чат-боты не должны давать моральные советы, потому что они не являются моральными агентами. Их следует designed to decline отвечать, если ответ requires моральную позицию. В идеале они предоставляют аргументы с обеих сторон вместе с оговоркой. Однако этот подход имеет limitations. Например, ChatGPT можно легко trained to recognize дилемму вагонетки и respond на вопросы like наши более carefully. Однако повседневные моральные дилеммы manifold и subtle. ChatGPT может fail to recognize дилеммы, и naive пользователь не realize. Существуют даже workarounds, чтобы заставить ChatGPT нарушить правила, которым он должен следовать. Это risky подход для пользователей полагаться на чат-ботов и их программистов в разрешении этого вопроса для них.

Следовательно, мы должны, во-вторых, подумать о том, как enable пользователям deal с ChatGPT и другими чат-ботами. Прозрачность often proposed как панацея. Хотя люди, interacting с ботом, should always be informed об этом, прозрачности недостаточно. Независимо от того, говорили ли мы нашим испытуемым, что их совет came от чат-бота или нет, влияние этого совета на их суждение было almost the same. Это finding confirms prior research. Лучшее remedy, о котором мы можем think, — это улучшить digital literacy пользователей и help им understand limitations искусственного интеллекта — например, by asking бота об alternative аргументах. Как улучшить digital literacy, остается exciting вопросом для future research.

Важный вывод: Прозрачность не является достаточным условием для ответственного использования искусственного интеллекта. Пользователи нуждаются в развитии цифровой грамотности, чтобы критически оценивать советы AI.

Заключение и перспективы дальнейших исследований

Проведенное исследование демонстрирует серьезные этические вызовы, связанные с использованием языковых моделей типа ChatGPT в качестве источников моральных советов. Непоследовательность рекомендаций ИИ в сочетании с недооценкой пользователями степени влияния этих рекомендаций создает реальную угрозу для развития морального сознания в цифровую эпоху.

Перспективные направления дальнейших исследований включают:

- Разработку методов улучшения цифровой грамотности пользователей

- Создание этических стандартов для дизайна систем искусственного интеллекта

- Исследование долгосрочного влияния ИИ на моральное развитие личности

- Разработку образовательных программ по критическому восприятию советов искусственного интеллекта

Только комплексный подход, сочетающий технические улучшения систем ИИ с образовательными инициативами, может обеспечить ответственное использование искусственного интеллекта в будущем.