Интересное сегодня

Как угол обзора и периферическое зрение влияют на защиту в б...

Введение в исследование периферического зрения в баскетболе Баскетболистам необходимо одновременно в...

Возрастные изменения вестибулярного восприятия движения и их...

Возрастные изменения в вестибулярном восприятии движения и их связь с контролем позы Падения являют...

Влияние виртуальной реальности на восприятие времени: Новые ...

Первый раз, когда я использовал виртуальную реальность (VR), меня поразило, насколько полностью она ...

Нейроны и глиальные клетки: различия и их роль в нервной сис...

Нейроны и глиальные клетки: основные различия Нейроны и глиальные клетки — это два основных типа кле...

Определение размера выборки в байесовском анализе для продол...

Введение Важной частью планирования эксперимента является определение необходимого размера выборки д...

Как тревожность влияет на принятие решений: причины и способ...

Как тревожность влияет на принятие решений? Тревожные расстройства могут значительно нарушать процес...

Введение

На фоне стремительного развития интернет-технологий социальные сети неразрывно вплелись в повседневную жизнь, став ключевыми площадками для обмена и выражения эмоций и настроений. Посредством текстовых публикаций, общих изображений и записанных видео люди передают свои эмоциональные переживания в разнообразных формах, превращая социальные сети в богатые хранилища эмоционального контента. Изменения этих эмоций служат ощутимым отражением психологической динамики пользователей, предоставляя исследователям бесценные insights в genesis, articulation и ramifications эмоций [1].

Мультимодальный анализ эмоций

В стремлении глубже проникнуть в суть эмоций ученые начали тщательное изучение emotion computation и recognition через призму психологии, используя мощь технологии мультимодального анализа настроений [2,3,4]. Эта инновационная технология использует множество модальностей, включая текст, речь, выражения лица и язык тела, чтобы всесторонне и точно захватывать и анализировать эмоциональные состояния. По мере развития технологий сфера мультимодального анализа настроений расширилась до области emotion fusion perception.

Восприятие эмоционального слияния

Emotion fusion perception entails тщательную настройку на эмоциональные состояния других, а также собственную эмоциональную интеграцию и реакции во время социальных взаимодействий. Этот процесс не только составляет ключевой аспект индивидуального эмоционального когнитивного развития, но и является незаменимым элементом социального взаимодействия и межличностных отношений [5]. В сфере интеграции восприятия эмоций люди должны обладать необходимым уровнем эмоциональной проницательности, чтобы умело расшифровывать эмоциональные сигналы, исходящие от других.

Связанные работы

Поведение пользователей социальных сетей

В отличие от face-to-face общения, асинхронный характер взаимодействий в социальных сетях предоставляет людям большую степень контроля, fostering чувство комфорта в формировании своего self-image и стиля общения. Эта характеристика способствует nuanced self-presentation на социальных платформах. Важно отметить, что определенное поведение, казалось бы, противоречащее целям управления впечатлением, часто является стратегическим маневром, предназначенным для привлечения определенной аудитории.

Анализ на основе глубокого обучения

Affective Image Content Analysis (AICA) [15] aims discern когнитивно-уровневую semantic информацию и идентифицировать эмоции, evoked изображением для зрителя или большинства. Использование AICA для inference эмоциональных состояний может помочь обнаружить проблемы с психическим здоровьем, identify эмоциональные аномалии и reduce риск экстремального поведения.

Дизайн модели

В этой статье предлагается crossmodal BERT emotion fusion perception и quantization метод, основанный на слиянии визуальных, аудио и текстовых модальностей. Подход интегрирует существующие unimodal алгоритмы глубокого обучения для трех источников модальных данных — изображение, аудио и текст — в контексте сайтов социальных сетей, как показано на рисунке 1.

Извлечение признаков

Рисунок 2 иллюстрирует процесс извлечения и анализа речевых модальностей в видео. Изначально raw речевые сигналы извлекаются с использованием библиотеки Librosa. Эти сигналы subsequently обрабатываются AudioSubNet, аудио-специфичной подсетью, которая использует sophisticated стратегию слияния, интегрирующую speech spectrograms со statistical признаками для точного capture аудио характеристик.

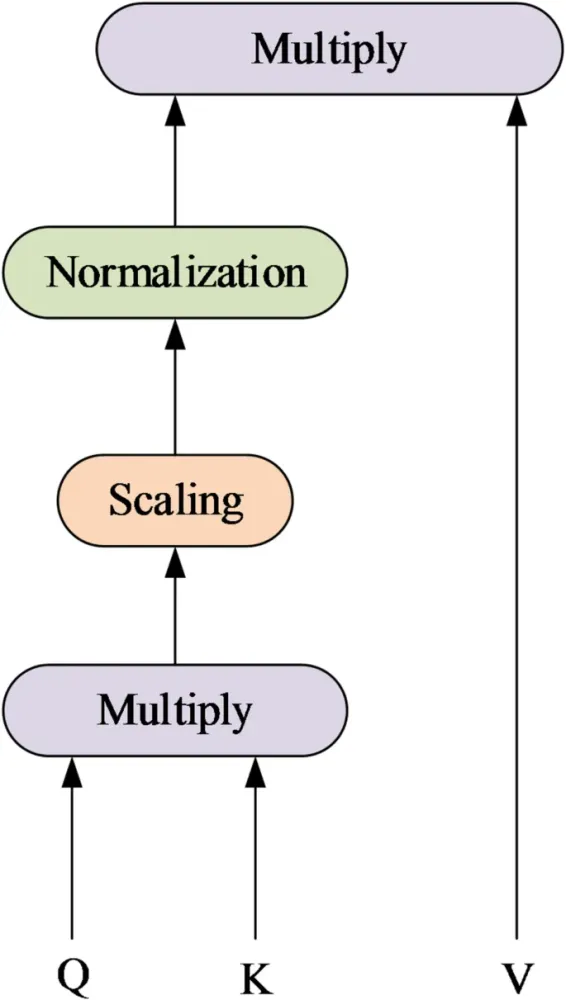

Модуль MMA

В социальных сетях, driven психологическими факторами, люди часто занимаются image scanning во время просмотра, устанавливая focal point интереса. Как только этот фокус установлен, heightened внимание направляется на этот конкретный аспект контента, aimed at приобретение более detailed информации при filtering out отвлекающих элементов.

Эксперименты и анализ

Наборы данных

В этой статье используются два набора данных настроений, полученных из социальных сетей, а именно CMUMOSI и CMUMOSEI, для оценки эффективности модели. Набор данных CMUMOSI, курированный исследователями Университета Карнеги-Меллон, включает приблизительно 93 часа видеоматериалов, состоящих из 2,199 клипов.

Оценочные показатели

В этой статье два фундаментальных metrics, accuracy и F1 value, служат quantitative мерами для оценки эффективности модели анализа sentiment energy. Accuracy rate provides всестороннюю оценку производительности модели across всех samples, serving как crucial indicator её точности.

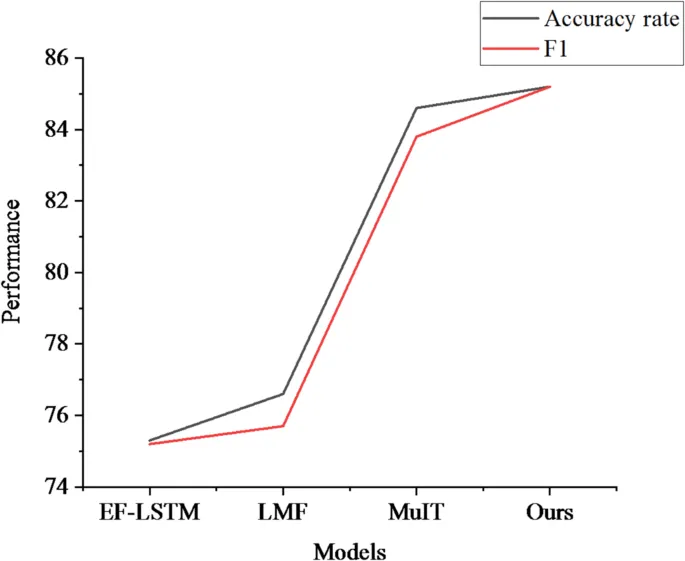

Сравнительный анализ моделей

Сначала в этой статье проводится сравнительный эксперимент по производительности модели на наборе данных CMUMOSI, и результаты представлены на рисунке 4. В то время как метод EFLSTM обрабатывает sequence data, используя характеристики LSTM, его эффективность ограничена из-за limitations LSTM в обработке long sequence информации.

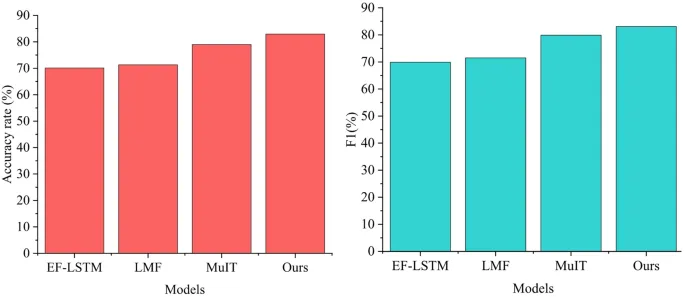

Анализ экспериментов по абляции

В этом разделе проводятся эксперименты по абляции, чтобы глубже изучить disparity в эффективности между crossmodal и unimodal подходами в классификации эмоций, elucidating преимущества emotion fusion perceptual обработки. Результаты, изображенные на рисунке 7, подчеркивают значительную неэффективность reliance исключительно на unimodal алгоритмические модели для классификации эмоций.

Обсуждение

В этой статье в контексте центра психологии социальных сетей предлагается мультимодальная модель распознавания слияния эмоций. Модель извлекает признаки аудио режима и режима изображения, introduces текстовую последовательность и использует механизм внимания для эффективной интеграции информации об изображении и аудио в видео в features текстовой модальности.

Заключение

В этой статье предлагается мультимодальная модель распознавания слияния эмоций, основанная на Психологическом центре социальных сетей. Путем улучшения извлечения признаков в аудио и визуальных модальностях и включения текстовых последовательностей introduced crossmodal BERT модель для визуального, аудио и текстового слияния.