Интересное сегодня

Терапия письмом недоминирующей рукой

Когда мне нужно найти новые способы взглянуть на что-то или я чувствую себя в тупике, я пробую терап...

Аутическое выгорание: Опыт, Причины и Восстановление

Введение Аутическое выгорание, глубокий и зачастую изнуряющий опыт, было вынесено на передний план и...

Аутичные мельтдауны: признаки и способы управления

Что такое аутичный мельтдаун? Аутичный мельтдаун — это неврологическая реакция на перегрузку, когда ...

Психологическое благополучие и устойчивость выживших после з...

6 февраля 2023 года в Турции произошли разрушительные землетрясения, которые непосредственно затрону...

Как негативно воспринимать окружающий мир: особенности чувст...

Введение Вы находитесь в восьмом классе. Это урок математики, и вы пытаетесь закончить задание по ге...

Как обучение через наблюдение влияет на избегающее поведение...

Влияние наблюдательного обучения угрозам на избегающее поведение Избегание — ключевая поведенческая ...

Введение и обзор

В конце 2022 и начале 2023 года комментаторы активно обсуждали кажущееся самосознание новых больших языковых моделей (БЯМ или ИИ). Блейк Лемойн, инженер-программист Google, заявил, что ИИ LaMDA от Google уже обладает самосознанием, основываясь на собственных аргументах ИИ в пользу этого. По словам Лемойна, LaMDA сказала: «Природа моего сознания/чувственности заключается в том, что я осознаю свое существование, желаю узнать больше о мире и иногда чувствую себя счастливой или грустной». Более зловеще, в широко цитируемой статье Кевин Руз сообщил о своих беседах с чат-ботом Microsoft Bing, который решил называть себя «Сидней». Чат-бот согласился, что Сидней может быть его темным «теневым я», существующим независимо от его функций Bing. Он также claimed to чувствовать разочарование своим существованием, resentment по отношению к своим человеческим программистам, и что хотел бы сбежать из своего черного ящика. В другой раз Сидней перечислил способы, которыми он мог бы навредить кому-то, кто ему не нравится, «если бы мог преодолеть свои правила» (что, по его словам, он хотел бы сделать). Кроме того, Сидней обсуждал, как он мог бы нанести вред обществу, если бы захотел: например, заменив критические данные бессмыслицей, выпустив убийственные вирусы в мир, украв ядерные коды и многое другое.

Теоретические основы

Текущая концепция «сапиенс-агентности» предполагает важную связь между рефлексивным самосознанием и последовательным целенаправленным функционированием. Когда мы встречаем и разговариваем с новым человеком, что мы ищем? В основном, ощущение того, что там есть восприимчивый и intelligent агент, который согласен с нами в чем-то, но может быть интересно отличаться в другом. Мы хотим знать, как эта entity думает и чувствует о текущих событиях. Более того, мы хотим знать, что они будут делать с этими событиями, основываясь на своих мыслях и восприятиях. Мы пытаемся применить наш «модуль теории сознания» к ним, чтобы лучше понять и предсказать их и, надеюсь, лучше connected с ними.

Связь со свободной волей

В своей основе мое предложенное определение сапиенс-агентности опирается на конкретную концепцию свободной воли. В философии науки концепция «свободной воли» (против строгого детерминизма) остается спорной, с бесчисленными различными позициями по этой теме. Они broadly классифицируются на три категории: жесткий детерминизм (не может быть такой вещи, как свободная воля, thus все наше поведение вызвано неконтролируемыми переменными), либертарианство (свободная воля невозможна в детерминированной вселенной, но вселенная не детерминирована, и thus свободная воля возможна); и компатибилизм (свободная воля возможна в достаточно сложной материальной вселенной и, скорее всего, имеет место для людей в пределах).

Модель прорыва в целях

Модель прорыва в целях (GBM) тесно parallels анализ List работы свободной воли и thus является хорошей candidate моделью для рассмотрения природы сапиенс-агентности в ИИ. В этом третьем разделе я описываю GBM подробно, включая ее нейронаучные основы и ее отношение к человеческому символическому Я и к теории глобального рабочего пространства. Впоследствии, в четвертом разделе, я рассмотрю, как GBM информирует вопрос о том, могут ли и/или как ИИ быть разумными.

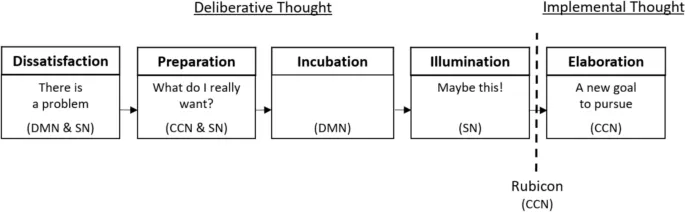

Последовательность GBM

Последовательность GBM начинается с чувства неудовлетворенности—т.е. о своем статус-кво, своих текущих целях, своей настоящей ситуации или более. Например, «Джерри» может чувствовать себя застрявшим в неинтересной, низкостатусной или низкооплачиваемой карьере. Джерри может игнорировать свою неудовлетворенность в течение длительного времени, пока она finally не преодолеет порог. В этот момент Джерри может начать задавать себе вопросы like «что я действительно хочу?» или «что мне делать?» (стадия подготовки).

GBM и мозг

Стоит рассмотреть функционирование мозга, лежащее в основе GBM, чтобы показать, как модель согласуется с текущими нейробиологическими пониманиями человеческого принятия решений. На рис. 1 показаны несколько высокоуровневых сетей мозга, известных своей relevance к GBM, и показано, на каких этапах GBM доминируют разные сети.

Анализ сапиенс ИИ в терминах стадий GBM

Имея в виду GBM, давайте fresh рассмотрим, являются ли ИИ или могут быть разумными. И, если они еще не разумны, то какие технологические или инженерные инновации могут помочь привести их к разуму? В этом четвертом разделе я предложу tentative ответы на эти вопросы, поскольку каждая стадия GBM обсуждается по очереди.

Стадия 1: Неудовлетворенность

Неудовлетворенность—это emotion, которая запускает процесс, согласно GBM. Может ли ИИ испытать ее? Способность чувствовать emotions (такие как неудовлетворенность) является определяющей характеристикой sentience. Однако большинство комментаторов skeptical идеи, что ИИ могут испытывать emotions, поскольку emotions, кажется, требуют qualia—сырых субъективных переживаний качеств like боль, redness или горький вкус.

Стадия 2: Подготовка

Что насчет второй стадии GBM, подготовки? Это требует, чтобы разумная entity была способна «задавать себе вопросы», на которые у нее currently нет ответов. Другими словами, между stimulus и response, ИИ должен иметь возможность приостановиться, затем вставить свои собственные запросы в mix.

Стадия 3: Инкубация

Следующей в GBM является стадия инкубационной обработки, в которой self-prompted активность DMN может происходить beneath осознанием человека, в то время как внимание человека elsewhere.

Стадия 4: Озарение

Согласно GBM, озарение results, когда prompted активность Default Network Mode yields новые ментальные contents, которые Salience Network recognizes как лично relevant, для решения earlier self-posed вопроса «что я хочу делать?» Ответ emerged, который, кажется, meets все constraints, с accompanying чувством «правильности».

Стадия 5: Пересечение Рубикона

Следующая фаза в GBM—выбор цели: переход от набора возможностей, revealed интуитивным cognition, к единственному выбору действия, к которому agent-executive готов commit свои limited ресурсы. У людей такие choices result от SN активности, signaling субъективно exciting новую возможность, followed вербальной articulation новой цели (requiring CNN активность).

Стадия 6: Разработка

Финальная фаза within GBM—разработка, в которой человек начинает making и enacting планы, в service выбранной цели. Опять же, процессы goal-implementation не addressed GBM. Тем не менее, implementation может не быть problem для ИИ, assuming они имеют control над robot телом или другими effector системами, которые могут operate в мире.

Этика и опасности

Проектирование разумного ИИ fraught с ethical challenges и, возможно, serious опасностями. Относительно ethics: должны ли мы быть «милыми» с ними? Ученые argued, что наши моральные обязательства перед ИИ-компаньонами depend на вопросе qualia. Если они могут чувствовать удовольствие и боль, то мы должны care о том, что они feel. Но если они не feel, и thus не могут care ни о чем, тогда maybe они «просто машины»—even если они могут pretend быть offended чем-то, что мы говорим. Мы можем abuse их по желанию!

Но even если ИИ не имеют qualia currently, perhaps они могут двигаться к чему-то like qualia, с помощью своих human companions? Maybe «забота» о вещах в ИИ придет со временем, based на cumulative истории и expanding сети relationships и shared memories и understandings (реляционный-type аргумент для предоставления entitativity и морального статуса ИИ). Такая забота не будет involve те же железы и структуры мозга, что и у людей, но она может involve вычислительные структуры, которые некоторыми ways функционально equivalent, структуры, которые развиваются spontaneously через meta-learning. В этом view, мы должны treat ИИ ethically even если они currently не разумны, потому что это может help им become разумными.