Интересное сегодня

Как поддержка родителей и самоконтроль снижают негативные мы...

Введение Социальное тревожное расстройство (СМР) является одним из самых распространенных психически...

Новые исследования о биоритмах и биполярном расстройстве

Введение Недавние исследования показывают, что колебания настроения при биполярном расстройстве регу...

Влияние старения на восприятие движущихся объектов через общ...

Введение Когда мы смотрим на окружающий мир, мы видим множество объектов. Во многих природных сценах...

Как эмоциональный интеллект влияет на реакцию подростков на ...

Введение Социальные сети могут быть значительным источником стресса для подростков (Orben et al., 20...

Социальное питье и его влияние на алкоголизм

Введение в социальное питье Когда мы представляем себе "типичного" алкоголика, многие из нас рисуют ...

Роль осознанности в уменьшении депрессивных симптомов у один...

Введение Одиночество признано важной глобальной проблемой здоровья. Исследования показывают, что оди...

Введение

Широкое использование термина «доверительный ИИ» вызывает дебаты среди производителей и законодателей. Некоторые философы утверждают, что доверять машинам иррационально, и доверие должно быть направлено на людей, ответственных за разработку и внедрение ИИ. Другие, такие как Coeckelbergh, утверждают, что доверие к машинам должно быть распространено, как и к другим социальным агентам.

Те, кто выступают против доверия машинам, утверждают, что доверие может быть рационально применено только к агентам, чувствительным к нормативным ограничениям, действующим с благосклонностью или обладающим моральной чувствительностью. Современные машины не обладают этими качествами, поэтому многие специалисты по этике ИИ предлагают использовать понятие надежности вместо доверия.

Методы

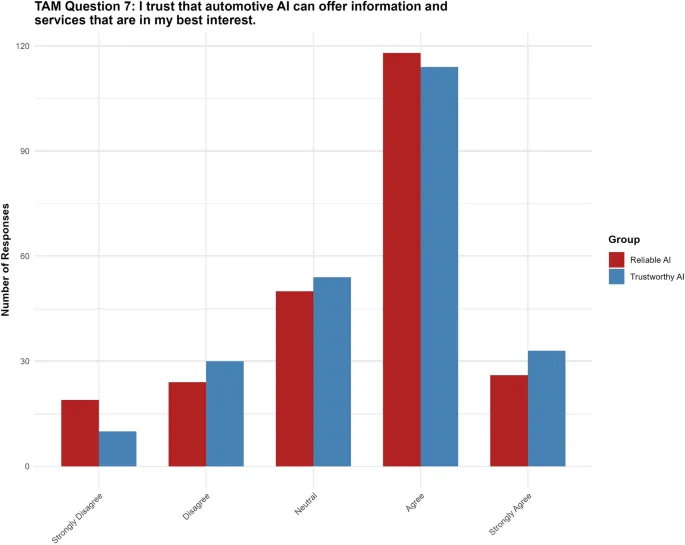

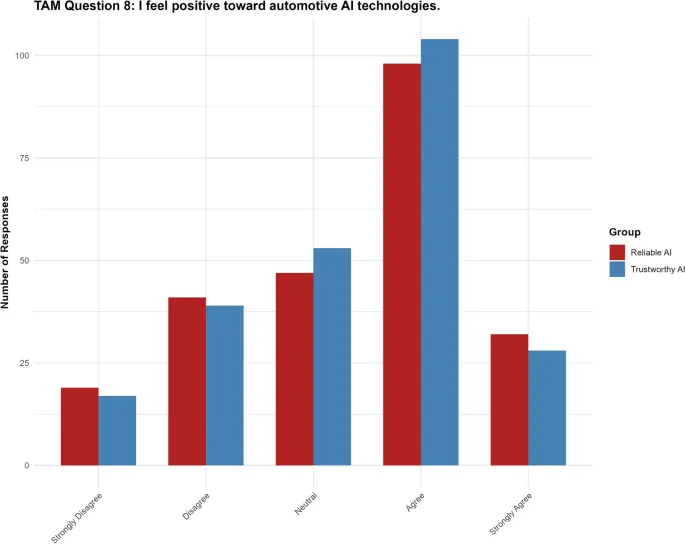

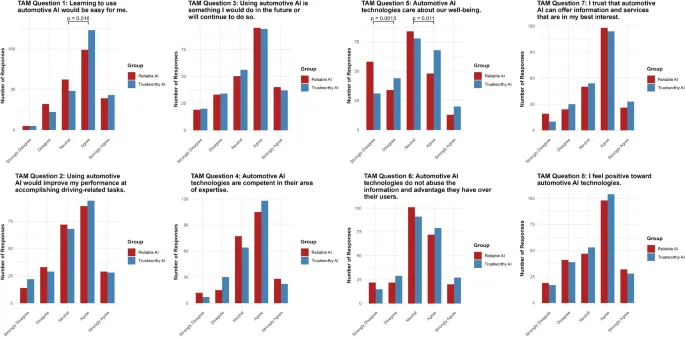

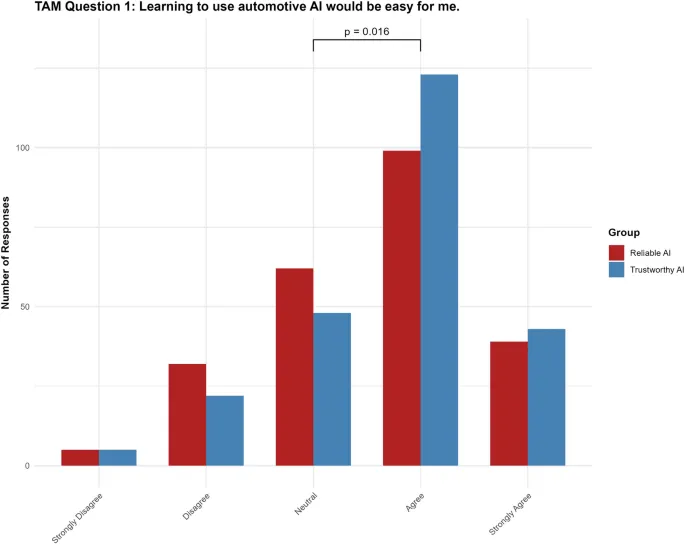

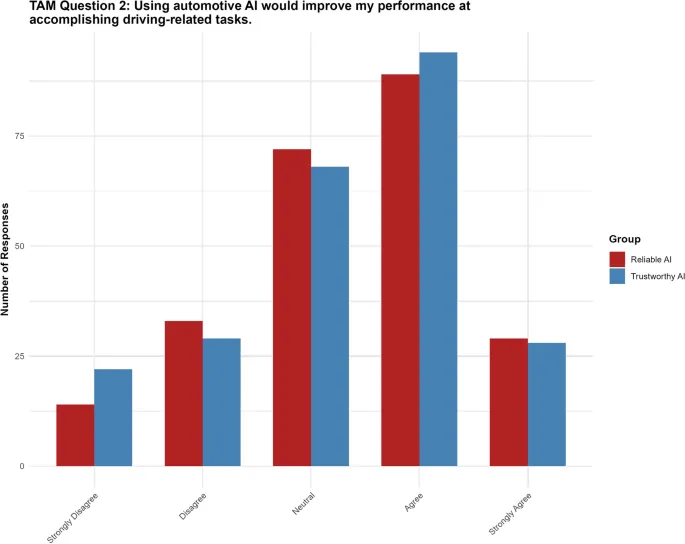

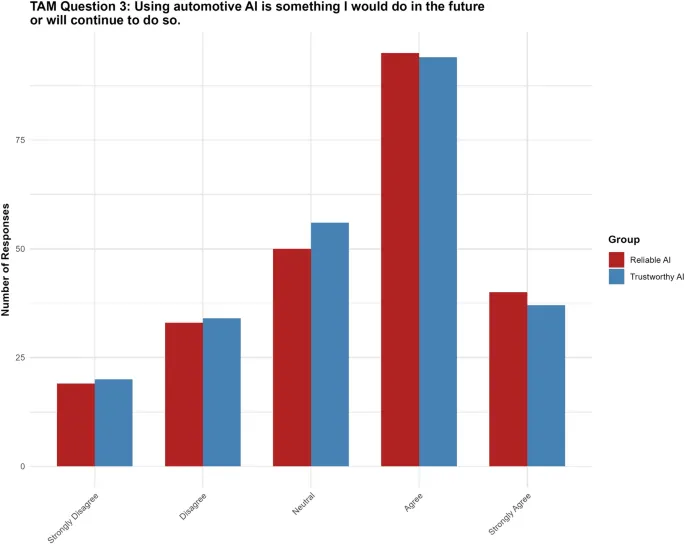

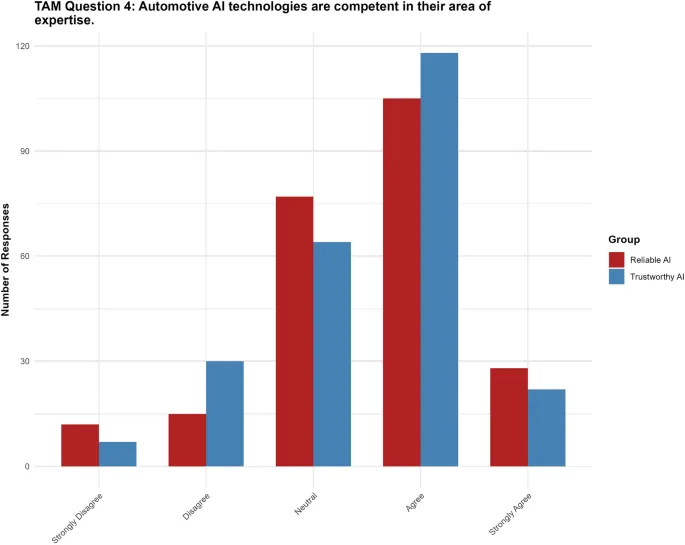

Исследование использует однофакторный межгрупповой дизайн с 478 участниками, разделенными на две группы: «доверительный ИИ» и «надежный ИИ». Участники оценивали три сценария и заполняли модифицированную версию Модели принятия технологии (TAM), которая охватывает различные переменные, такие как воспринимаемая легкость использования, человекоподобное доверие и общее отношение.

Результаты

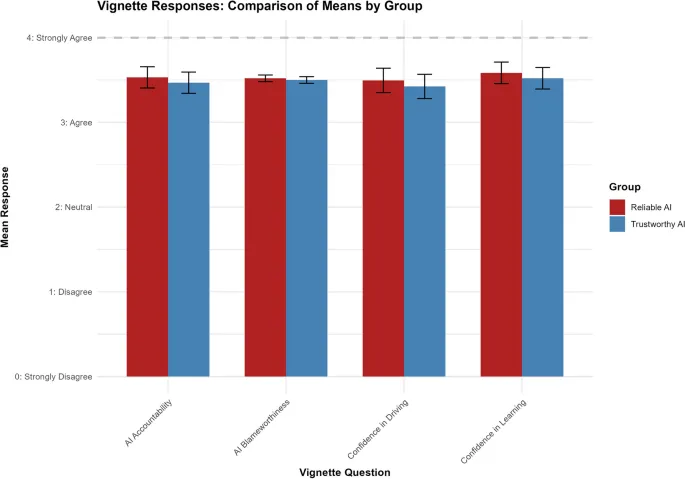

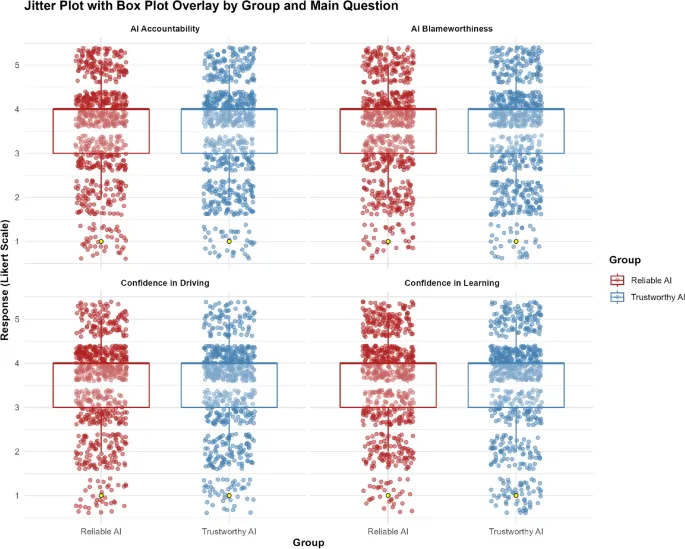

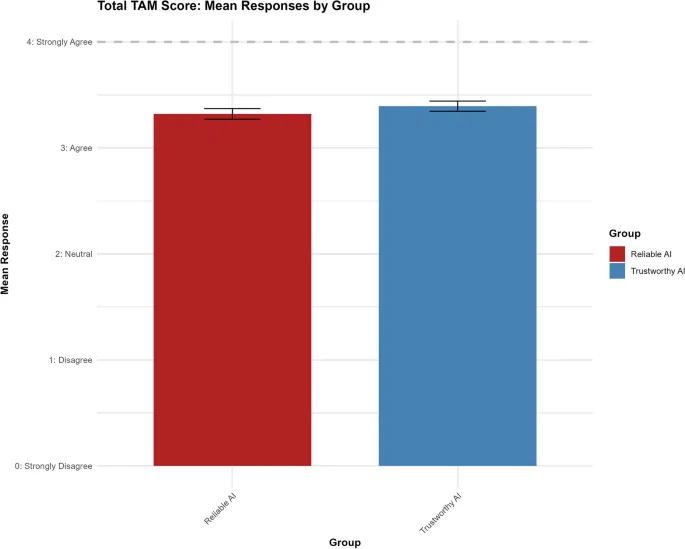

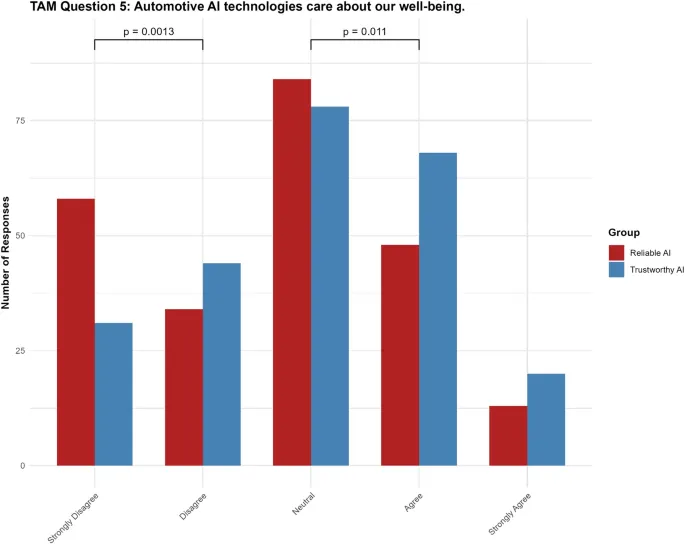

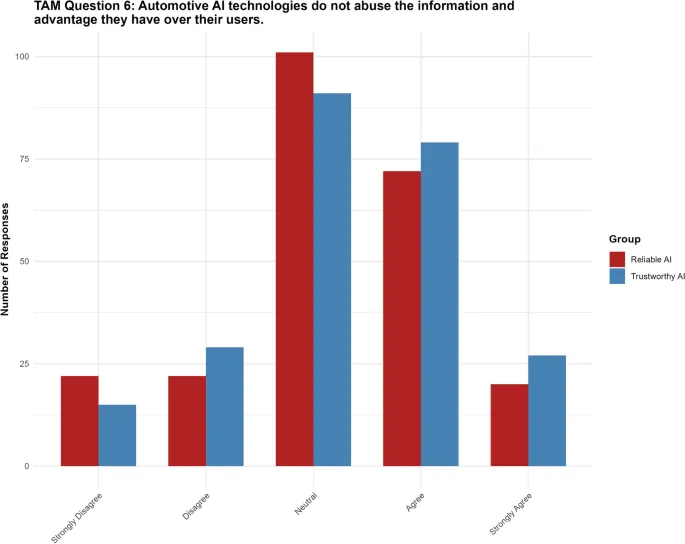

Маркировка ИИ как «доверительного» не значительно влияла на суждения участников по конкретным сценариям, но увеличивала воспринимаемую легкость использования и человекоподобное доверие, что указывает на влияние на удобство использования и антропоморфизацию восприятия пользователей.

Обсуждение

Исследование показало, что маркировка ИИ как «доверительного» не значительно влияет на оценки пользователей или принятие технологии, за исключением увеличения восприятия ИИ как заботящегося о благополучии людей. Эти результаты имеют важные практические и этические последствия для разработчиков и политиков.

Ограничения

Исследование имеет несколько ограничений, включая возможное влияние фрейминга на восприятие участников и необходимость дальнейших исследований для оценки влияния маркировки на другие технологии ИИ.

Заключение

Маркировка ИИ как «доверительного» или «надежного» не значительно влияет на оценки пользователей или принятие технологии, за исключением восприятия ИИ как заботящегося о благополучии людей. Эти результаты подчеркивают важность использования надежности вместо доверия в разработке и внедрении ИИ.